Что такое парсинг новостников — и почему на этом зарабатывают

Если открыть любой новостной сайт — от РБК до региональной газеты — может показаться, что это просто набор текстов. Но для специалиста — это поток структурированной информации: заголовки, даты, категории, имена, бренды, цифры.

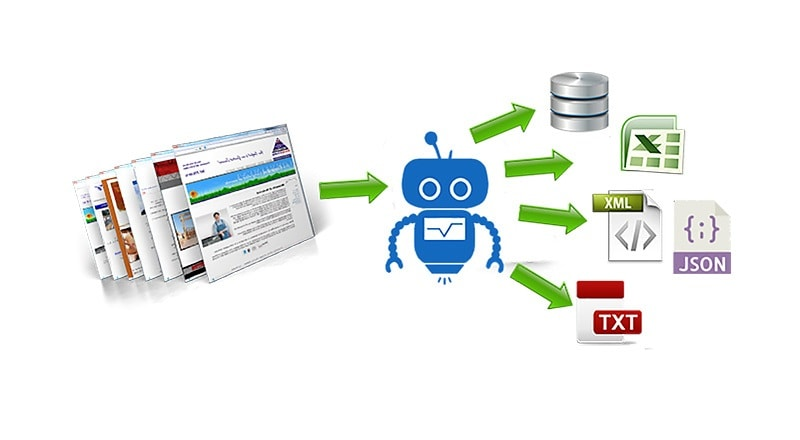

А теперь представь: ты можешь автоматом собирать это всё, фильтровать, анализировать и использовать. Именно этим и занимается парсер новостников.

Что полезного можно найти в новостниках?

Из новостных сайтов можно забрать массу интересного:

Упоминания брендов и персон. Компании мониторят, где и как их упомянули: в положительном или негативном ключе. Это важно для репутации, PR и работы с отзывами (SERM).

Актуальные инфоповоды. Что обсуждают прямо сейчас? На какие темы можно запускать рекламу, собирать трафик, делать Telegram-каналы или пуш-рассылки?

Контент для агрегаторов. Сайты и каналы, которые сами не пишут, а собирают новости со всего интернета и подают под своей обложкой.

SEO и наполнение сайтов. Порталы, которые делают органику на новостном контенте: авто, финансы, медицина, недвижимость.

Маркетинг и аналитика. Отслеживание трендов, экономических новостей, курсов, госрегулирования — для бизнес-решений.

Представь, что нужно не просто «почитать» раз — а каждый час получать статьи, отфильтрованные по нужным темам, регионам, ключам. Вручную это невозможно. Значит, нужна автоматизация — парсер.

Кому нужен парсинг новостей — и как он устроен

Новостной парсинг используют не только крупные медиа и агентства. Вот кто работает с этим каждый день:

SERM-специалист

Один негативный заголовок — и бренд уже в топе Яндекса рядом с уголовной хроникой. SERM-специалист парсит новостники и агрегаторы (от РБК до местных изданий), чтобы оперативно отрабатывать упоминания. Пока PR-служба конкурента спит — он уже залил нейтральный контент и закрыл волну.

SEO-команда

Взяли 100 новостей по тематике «микрозаймов» за неделю, прогнали через парсер, размечали и сгенерили под каждый регион «новостную обвязку».

Итог — 100 страниц в индексе, рост охвата по хвостам, регулярное обновление — и всё это без ручной писанины.

Арбитражник

Утром на Ведомостях вышла новость про запрет фастфуда. Через 15 минут скрипт уже вытащил заголовок и подставил его в Telegram-преленд, к которому привязан оффер по доставке еды. На волне паники зашло x3 ROI. Без автоматического парсера пришлось бы делать всё вручную — и упустить момент.

Чтобы такой парсер стабильно тянул новости с разных источников без блокировок, лучше сразу купить прокси — это избавит от банов по IP и снимет ограничения по скорости.

Финансист

Команда аналитиков делает ежедневный дайджест новостей про нефть, газ, экспорт зерна. Источники — 30+ новостников. Парсер собирает статьи по ключам, ранжирует по свежести и гео. За 10 минут готов текст, который читают клиенты и поставщики. Главное — быть быстрее, чем конкуренты.

Telegram-редактор

Редактор медиканала запускает парсер: он вытягивает 5 новостей из 10 медиа, убирает повторения, оформляет их в посты и заливает в отложку через API. Всё — канал живёт сам. Даже если редактор в отпуске или спит.

ML-разработчик

Команда делает чат-бота, который отвечает на юридические вопросы. Чтобы он знал про новые законы и кейсы, нужен поток новостей. Парсинг — способ каждый день докармливать модель реальными текстами. Без этого бот станет бесполезным через 2 недели.

Как это всё работает:

Собираешь список сайтов: от ТАСС и РБК до «Аргументов и фактов» или местных СМИ.

Настраиваешь парсер: чаще всего это Python-скрипты, Datacol или фреймворки на Puppeteer, Playwright.

Указываешь, какие данные нужны: заголовок, тело, дата, автор, категории, ссылки.

Запускаешь в фоновом режиме — и получаешь поток структурированных данных.

Но есть один нюанс, который ломает систему.

Зачем нужны прокси при парсинге новостников

Сайты не хотят, чтобы их парсили. Они отслеживают частоту запросов, проверяют заголовки, банят по IP. Особенно это касается:

крупных порталов с защитой (РИА, Коммерсантъ, Forbes);

сайтов на Cloudflare и аналогичных платформах;

региональных изданий, у которых низкий лимит на обращения.

Проблемы начинаются сразу:

через 50–100 запросов вылетает 403 Forbidden;

сайт начинает кидать капчу;

соединение обрывается с таймаутом;

выдается пустая страница или редирект на главную.

Без прокси ты быстро попадешь в бан. Один IP = один бот в глазах сервера.

А теперь главное: чтобы избежать этого, нужно использовать прокси, которые скрывают настоящий IP, позволяют распределить нагрузку и имитировать «живой» трафик.

Причём не любые, а именно ротационные резидентские прокси с поддержкой HTTPS и распределением по гео. Почему?

Ротация дает уникальный IP на каждый запрос или сессии.

Резидентский тип выглядит как обычный пользователь (а не дата-центр).

Гео позволяет получать региональную выдачу (например, для Калининграда или Казани).

Скорость и стабильность — критичны при сборе потока данных.

Именно поэтому разработчики парсеров и команды, которые работают с новостниками, используют ротационные прокси от Proxys.io — сервис, который предлагает:

пул из 12 млн+ IP по всему миру;

гибкую ротацию (по времени или запросу);

высокую скорость и SLA 99,9%;

поддержку SOCKS5 и HTTPS;

панель управления и фильтрацию по странам, ASN, городам.

Если парсишь новостники — прокси не опция, а необходимость. Один сбой по IP, и ты теряешь весь поток: или получаешь капчу, или просто блок. Поэтому важно выбрать стабильный пул, заточенный под постоянную нагрузку.

Поддержка большого пула IP, высокая скорость подключения и гибкие настройки — всё это можно найти на сервисе аренды прокси серверов. Не экономь на инструменте, если хочешь получать данные, а не ошибки.